关于信息熵的一些探讨和思考

关于信息熵的一些探讨和思考

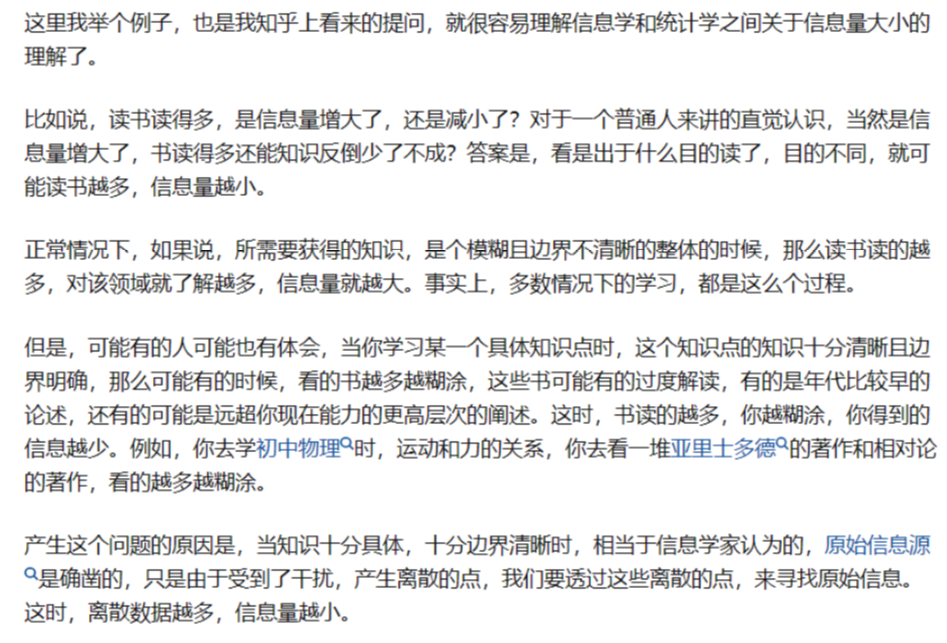

- 信息熵越大,信息量是越大还是越小?

- 信息熵:代表信息传递的不确定性的大小/衡量随机事件发生的不确定性

- 主要分为两个方向考虑 信息学和统计学

-

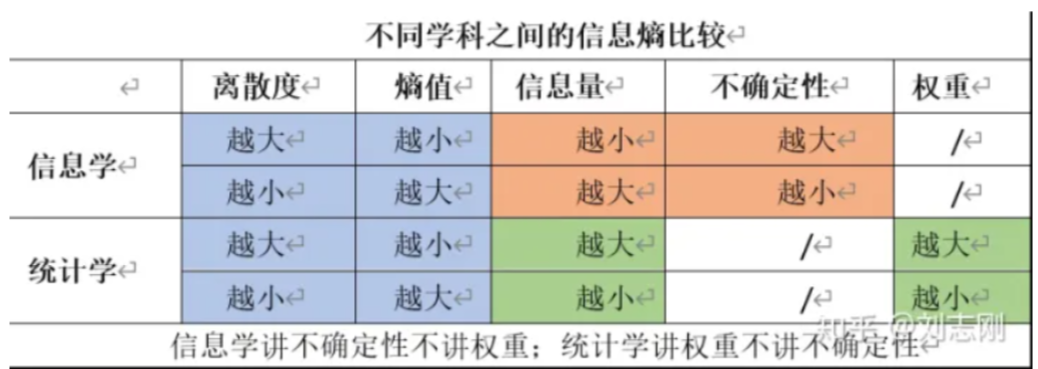

==在信息学中==,关心的信息的正确传递和接收,信息熵实则是用于衡量信息传递中受到干扰而产生的不确定性的衡量数值(接收的数值和真实的数值)

- 观点:认为数据原始状态就是离散的,且不同离散度代表不同的指标特性

- 使用香农公式算出的值,叫做信息熵值(在熵权法中称为冗余度值or偏离度值)

- 信息熵值(或熵权法中的冗余度值or偏离度值):在一个确定无疑的信息源发送的信息,受到干扰后,衡量偏离原始精确信息的程度。

- 因此,离散度越大,信息熵值越小,消息越不可靠,得到信息越小;离散度越小,信息熵越大,消息可靠,得到的信息越大

-

==在统计学中==,有一个方法称为熵权法

- 观点:认为原本就有确定无疑的数据,是受到干扰(发送主体是可以为很多的主体or主体不同时间不同地点)才形成离散性的数据的

- 因此,离散值越大,熵值越小,代表信息量越大,权重越大(所以在公式信息熵权重法过程中需要用1-熵权值,使得熵权值和权重正负方向统一起来)

- 通过实例分析(批判的看)

- 其实这个问题是一个很简单并且需要深入思考的问题,我认为秉持什么观点从什么角度出发,根据不同的题目和场景需求进行分类或者区分,非常的重要。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Hello! I am William Yang!!

评论

ValineDisqus